AIの脳地図で判明:記憶と推論は別領域に

研究報道は、ChatGPTのような大規模言語モデルで記憶と推論が別領域に分かれている可能性を示しましたが、手法の詳細公開と独立検証が急務です。

AIの“脳地図”が見せた驚きの分離

突然ですが、AIの内部を“地図”に例えると、そこには街区のような区分があるかもしれません。TechXploreの報道によれば、研究チームはChatGPTのような大規模言語モデル(LLM)を解析し、「記憶」と「推論」が別々の領域に対応しているように見えると報告しました。

大規模言語モデル(LLM)とは、たくさんの文章を学習して言葉を生成するAIのことです。簡単に言うと、膨大な“言葉の辞書”と“計算の仕組み”を兼ね備えた巨大なシステムです。

何が観察されたのか

報道が伝える観察結果は次の通りです。ある種の**過去に学習した知識や事例(記憶)**と、**推論や計算に関わる処理(推論)**が、ネットワーク内部で物理的または機能的に別の領域に対応しているように見えた、という点です。

イメージとしては、街の“図書館エリア(記憶)”と“工場エリア(推論)”がはっきり分かれているようなものです。図書館から本を取り出し、工場でその本を素材に組み立てて結論を出す。そんな風景を想像していただければ近いでしょう。

解析の狙いと手法(簡潔に)

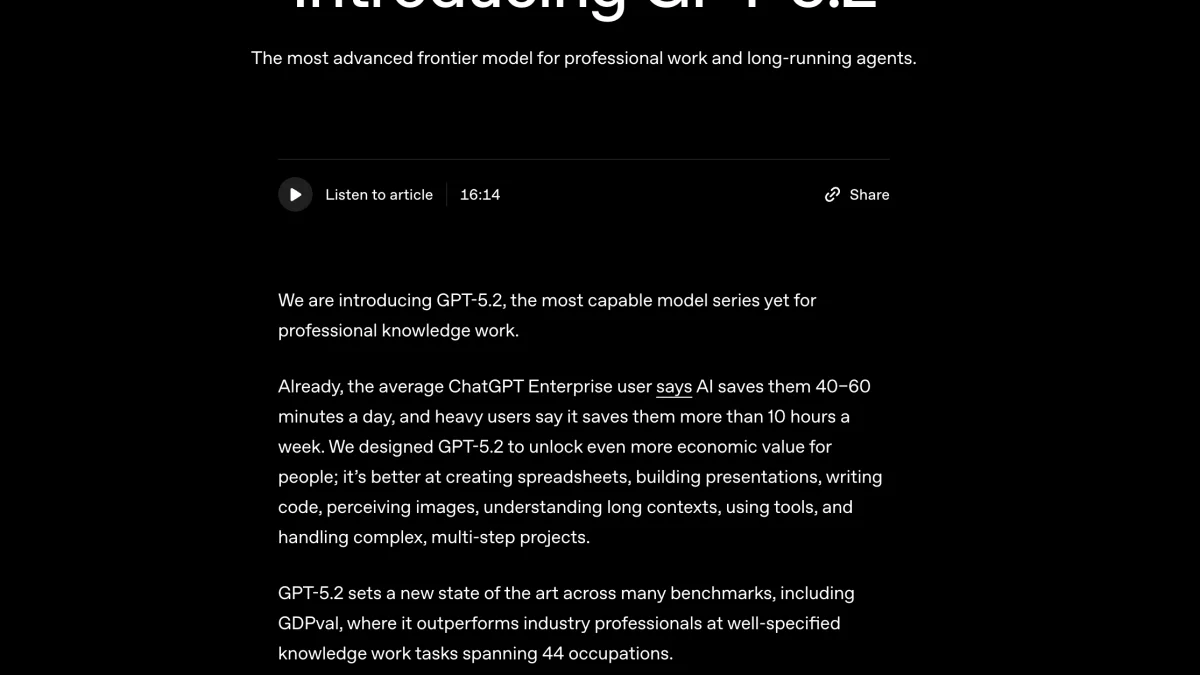

研究者たちは、モデルがどこに情報を蓄え、どのように使っているかを明らかにするために活動パターンや表現の分布を「マッピング」しました。こうした手法は、層ごとの活性化や重みの分布、表現間の類似度などを組み合わせて行われます。

ただし、TechXploreの記事では手法の細部や定量的な指標は詳述されていません。どの指標が決定的だったかは、元論文の公開を待つ必要があります。

解釈の注意点 — 早合点は禁物です

内部マッピングの結果は、手法やモデルの種類で大きく変わることがあります。つまり、今回の観察が一般的に当てはまるかは未知です。報道だけで結論を出すのは危険です。

ここで重要なのは、元データと解析コードの公開、そして独立した再現実験です。研究の透明性が確認されて初めて、広い応用を議論できます。

実務へのインパクト(期待と現実)

もしこの分離が確かなら、開発者には大きな利点があります。例えば、誤情報(いわゆるハルシネーション)が出たとき、原因となる領域を局所的に検査して修正する――といった診断が可能になるかもしれません。

利用者にとっても、どの部分が“記憶”でどこが“推論”かが分かれば、出力の信頼性評価がしやすくなります。ただし、こうした恩恵が広く行き渡るには時間がかかります。高度な解析には専門知識と計算資源が必要ですし、運用規則や制度設計も整える必要があります。

今後に望むこと

第一に、元研究の手法とデータの公開が急務です。次に、研究コミュニティによる追試と比較が必要です。これらが進めば、どの程度一般化できる現象かが見えてきます。

最後に一言。今回の報告は、AI内部の可視化に向けた興味深い一歩です。ですが結論はまだ“有望だが慎重に”です。元論文の公開と独立検証を待ちましょう。

皆さんも、次に出てくる詳細報告を一緒にチェックしてみてください。AIの“街区図”は、これからもっと細かく描かれていくはずです。