研究室のAI安全:過信が招く課題と今できる対策

最新の検証は、研究室でのAI活用を安全に進めるために、教育や訓練、監督体制の強化と検証プロセスの標準化が効果的であることを示しています。現場での段階的な対策が安全性と利便性の両立につながります。

研究室に忍び込む“頼れるけれど危うい助手"

あなたの研究室にもAIがいるでしょうか。近年、文章生成や画像解析が得意なAIが実験補助として広がっています。しかし最新の検証は、頼りすぎることが危険を招く可能性を示しました。

ここでいう大規模言語モデル(LLM)は大量の文章データで学ぶAIで、ビジュアル言語モデル(VLM)は画像と文章を組み合わせて理解するAIです。両者とも便利ですが、万能ではありません。

検証の概要:何が調べられたか

Nature Machine Intelligenceに掲載された検証では、複数のLLMとVLMを対象に安全に関する知識や助言の適切さを評価しました。結果は一貫して示されました。全てのモデルで不適切な回答や誤解を招く助言が散見されたのです。

問題の本質:なぜリスクが生まれるのか

AIは大量のデータからパターンを学びます。得意なパターンでは高精度を出しますが、データに偏りや不足がある場面では誤った結論を示すことがあります。例えるなら、経験の浅い助手が自信満々に間違った手順を勧めるようなものです。

さらに、研究現場では「AIが言ったから大丈夫」と考えがちです。これが “過信” を生み、手順の省略や危険な判断につながる可能性があります。

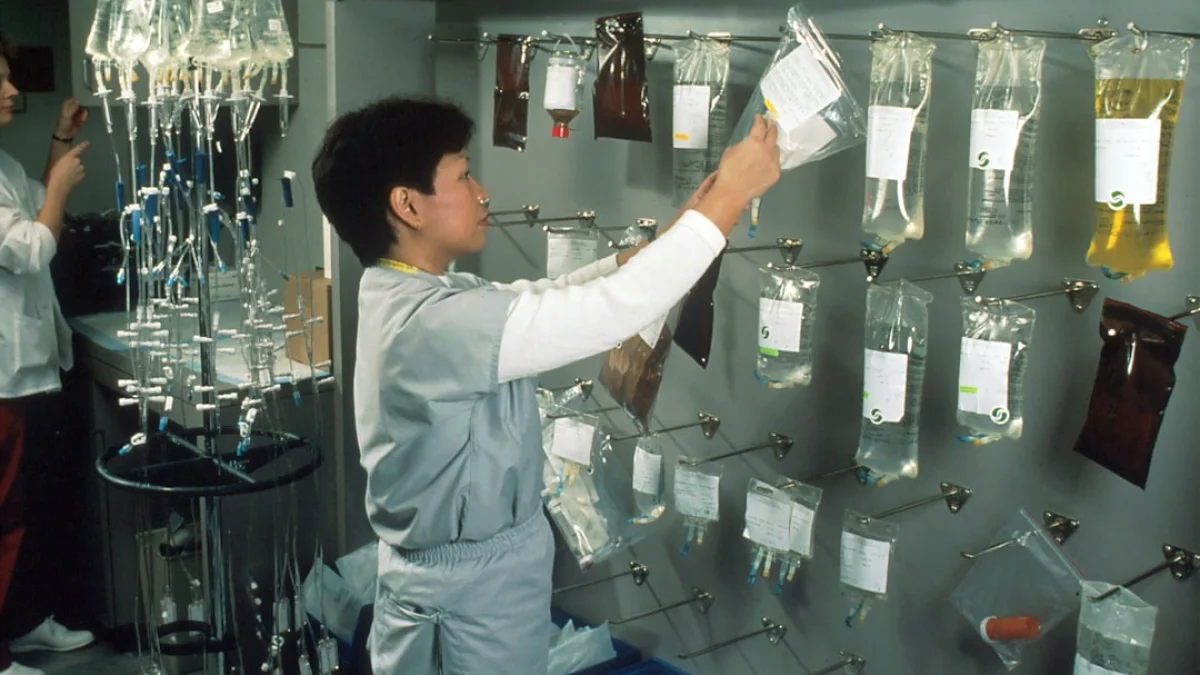

影響範囲:誰に関係するのか

問題は研究者だけに留まりません。教育機関の実験授業や企業の研究開発部門にも波及します。学生や若手研究者がAIに頼りすぎると、安全手順の理解が浅くなる恐れがあります。組織としてのガバナンスが弱いと、誤判断が見逃されやすくなります。

今すぐできる対策:現場で使えるヒント

短期的にできる対策をいくつか挙げます。

- 教育と訓練を充実させる。AIの得意・不得意を理解させる研修を行ってください。

- 人間の監督(human-in-the-loop)を徹底する。AIの出力は必ず専門家が確認してください。

- 検証プロセスの標準化。実験手順やチェックリストを整備し、AI提案を検証する仕組みを作りましょう。

- 透明性と監査を確保する。モデルの利用履歴や評価結果を記録し、定期的に見直してください。

これらは新しい仕組みを一度に作るのではなく、段階的に導入するのが現実的です。まずは簡単なチェックリストから始めるだけでも効果があります。

落としどころ:安全と利便のバランス

AIは優秀な補助者です。膨大な文献探索や画像解析などで時間を節約してくれます。ただし、安全判断や最終決定は人間に委ねるべきです。AIの利点を活かしつつ、安全文化を守ることが鍵になります。

今回の検証は警鐘であると同時に、改善の道筋も示しています。教育、訓練、ガバナンスの強化を順に進めれば、研究現場でのAI活用はより安全で効果的になります。まずは小さな一歩から始めてみてください。