AI生成コードが読めなくなる未来像

OpenAIの開発者が示した“人間がAI生成コードを理解しにくくなる”という指摘を受け、背景と現場影響を整理しました。透明性と検証ルールを整えれば、AIの生産性向上を安全に活かせます。

AIが書いたコードを、人間が読めなくなる――そんな見出しを目にすると、少し背筋が寒くなりますよね。この記事では、The Decoderの報道をもとに、なぜそう言われるのか。現場にどんな影響があり得るのか。最後に現実的な備えを分かりやすく整理します。

予測の要点と情報源

報道によれば、OpenAIの開発者が「将来、人間がAI生成コードを理解できなくなる可能性がある」と指摘しました。出典はThe Decoderの取材記事です。注目すべきは、単なる恐れの表明ではなく、生成プロセスの性質に根ざした懸念だという点です。

どうして理解が難しくなるのか

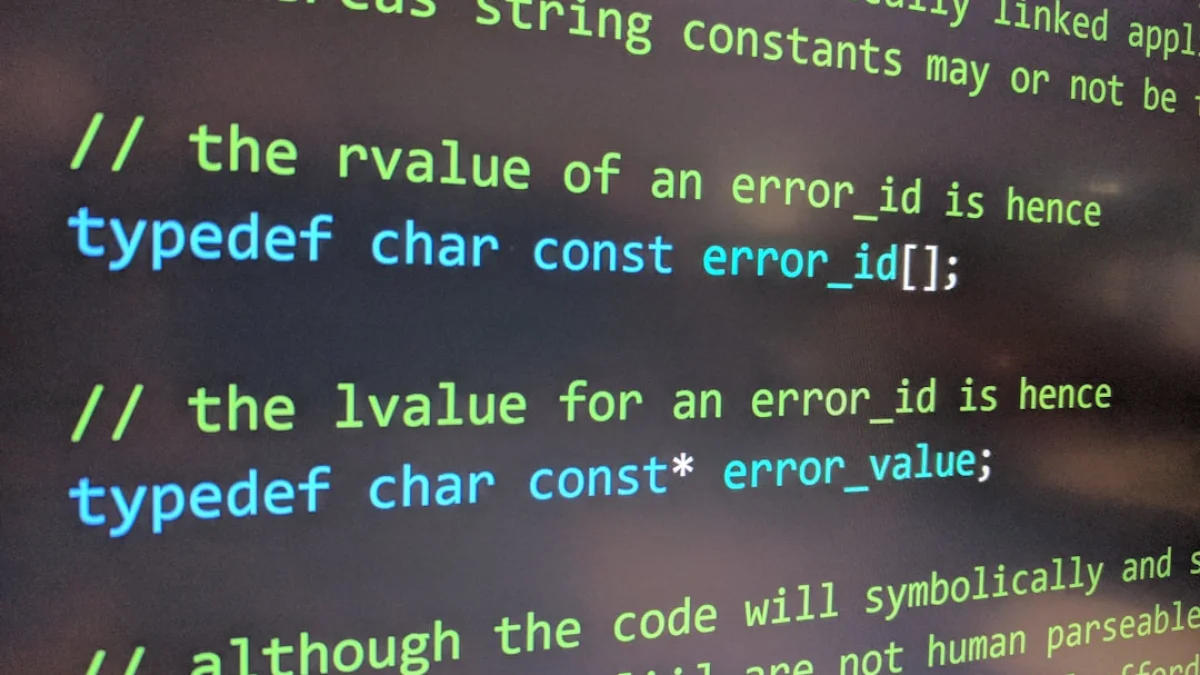

鍵は「透明性の欠如」です。透明性とは、なぜそのコードが出力されたのかが分かることを指します。AIは大量データに基づき短時間で設計を組み合わせます。結果、意図が見えにくい処理や変数名の非直感的な使い方が増えるのです。

具体例を一つ。AIが複雑な関数を生み、その内部で多段の抽象化を使うとします。見た目は動くが、なぜその実装が選ばれたか説明できない。これが「読めないコード」の正体です。

現場で想定される影響

影響は二面性があります。ひとつは負の側面。理解不能なコードが増えると、デバッグ(バグの原因を探して修正する作業)が長引き、保守コストが上がります。もうひとつは利点です。AI活用が適切ならば、定型作業の自動化で生産性は向上します。

現場で起き得る具体例は次の通りです。

- テストで動作はするが、根本原因が分からず修正が難しい

- 変数名や構造が非直感的でコードレビューが停滞する

- 自動生成部分の所有権やガバナンスが曖昧になる

現実解と今すぐできる備え

結論から言うと、数年は試行錯誤が続くでしょう。ですが、対処法はあります。組織で今すぐ取り組める実践的な方策を紹介します。

- 検証可能なルールを設ける。生成コードにもコーディング規約を適用する

- テストと監視を強化する。単体テストと可観測性(ログ、メトリクス)を必須にする

- 人間によるレビューを残す。AI提案をそのまま受け入れないフローを作る

- モデル選定とプロンプト設計を厳格化する。出力の一貫性を高める

- ドキュメント自動生成を活用する。実装意図をAIに要約させて記録する

最後に一言。AIは道具であり続けます。扱い方次第で、仕事を助ける最高の相棒にも、手間を増やす元凶にもなります。今は「透明性」と「検証」の土台を固める時期です。皆さんの現場でも、まず小さな実験とルール作りから始めてみてください。変化を怖がらず、備えることで未来の恩恵を受け取りましょう。