Tinker GA公開で広がるKimiK2と視覚AI活用

TinkerのGA公開で誰でも利用可能になり、長推論に強いKimi K2や視覚入力Qwen3-VLが加わって、開発効率と実務適用の幅が一気に広がります。

TinkerがついにGA(一般提供)になりました。待機リストが撤廃され、誰でもすぐに試せます。開発者にとっては新しい道具箱が手に入ったようなニュースです。ここでは何が変わるのかを、実務目線でやさしく解説します。

まずのポイント

- Tinkerは待機リストを廃止し、GA公開を開始しました。公式サイトからサインアップして利用できます。

- 新しい推論モデル「Kimi K2 Thinking」が追加されました。長い推論チェーンに強く、ツール連携を想定した設計です。

- OpenAI API互換のサンプリング機能が導入され、モデルからの出力取得が標準化されました。これは他プラットフォームとの連携を容易にします。

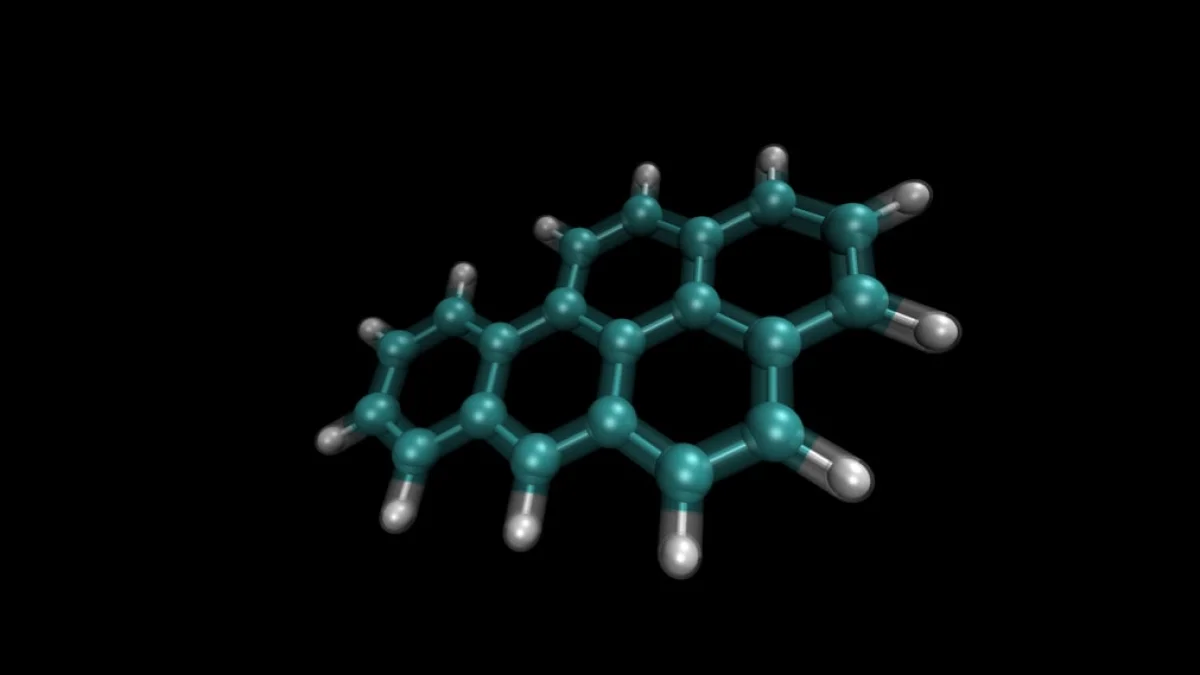

- 視覚入力に対応するQwen3-VLシリーズが加わり、画像とテキストを組み合わせた処理が可能になりました。

Kimi K2 Thinkingとは(ざっくり解説)

Kimi K2 Thinkingは長推論チェーンを得意とするモデルです。長推論チェーンとは、複雑な手順や多段階の意思決定を順に処理する能力を指します。例えるなら、複数の地図を照らし合わせて最適ルートを探すナビのようなものです。

主な特徴は次の通りです。

- 規模は1兆パラメータクラスで、Tinker上では最大級のモデル。

- ツール呼び出しや外部データを組み合わせた長い推論に向く設計。

- Tinker上で微調整(ファインチューニング)が可能で、業務向け適用の柔軟性が高い。

実務で使う際の注意点もあります。高性能を引き出すにはデータ品質が重要です。微調整の設計と評価基準をきちんと準備してください。適切な検証がなければ期待通りの結果は出にくい点に注意しましょう。

OpenAI API互換サンプリングの意味

今回の更新で「OpenAI API互換サンプリング」が標準機能になりました。簡単に言うと、OpenAIのAPIと同じ形でモデルにリクエストを出せるようになった、ということです。これにより既存の開発フローを変えずに移行できる可能性があります。

ただし、互換性があるとはいえ完全な同一挙動を保証するものではありません。パフォーマンス差や微妙な挙動の違いが出る場合があります。実運用前にプラットフォーム間での挙動確認をお勧めします。

Qwen3-VLによる視覚入力の実務価値

視覚モデルとしてQwen3-VLシリーズが追加されました。現時点で利用可能なのは以下の2モデルです。

- Qwen3-VL-30B-A3B-Instruct

- Qwen3-VL-235B-A22B-Instruct

入力はImageChunk(画像)とテキストチャンクを組み合わせて扱います。SFT(教師付き微調整)やRL finetuning(強化学習を使った微調整)にも対応し、画像分類やマルチモーダルな業務フローに組み込めます。

実験例として、Caltech 101やStanford Carsなどの古典的データセットで評価が行われています。特にQwen3-VL-235Bは、データ制限下でもDINOv2を上回る結果を示し、言語知識を組み込んだ視覚モデルの実用性を示唆しました。

視覚と言語を合わせると、画像の文脈解釈やレポート自動生成など、新たな応用が期待できます。

実務での使い方のアイデアと注意点

少し具体的な活用アイデアです。

- 複雑な承認フローの自動化:Kimi K2に業務ルールとデータを学習させ、判断補助に使う。例として契約審査の初期チェック。

- マルチモーダルな品質チェック:Qwen3-VLで画像検査と報告書の生成を組み合わせる。

- 開発効率の向上:OpenAI互換のサンプリングを使って既存ツールとの連携実験を素早く行う。

導入時の注意点は次の通りです。

- まずは小さなデータセットで検証してからスケールすること。品質が悪いデータは性能を大きく下げます。

- 評価指標とモニタリング体制を初めに作ること。期待値と実測値を比較しましょう。

- プラットフォーム間での挙動差を必ず確認すること。互換性に過信しないでください。

まとめと次の一手

TinkerのGA公開は、最先端モデルを誰でも触れるようにした大きな一歩です。Kimi K2は長推論やツール連携が必要な業務に向きます。Qwen3-VLは視覚を含むアプリケーションを現実的にします。OpenAI互換サンプリングは移行を助ける便利な機能です。

まずは公式ドキュメントとcookbookのコード例を確認し、小さな実験から始めてください。新しい道具は使い方次第で強力な武器になります。興味が湧いたら、実際に手を動かして挙動を確かめてみましょう。