Veo-3が生む「偽手術映像」の危険性

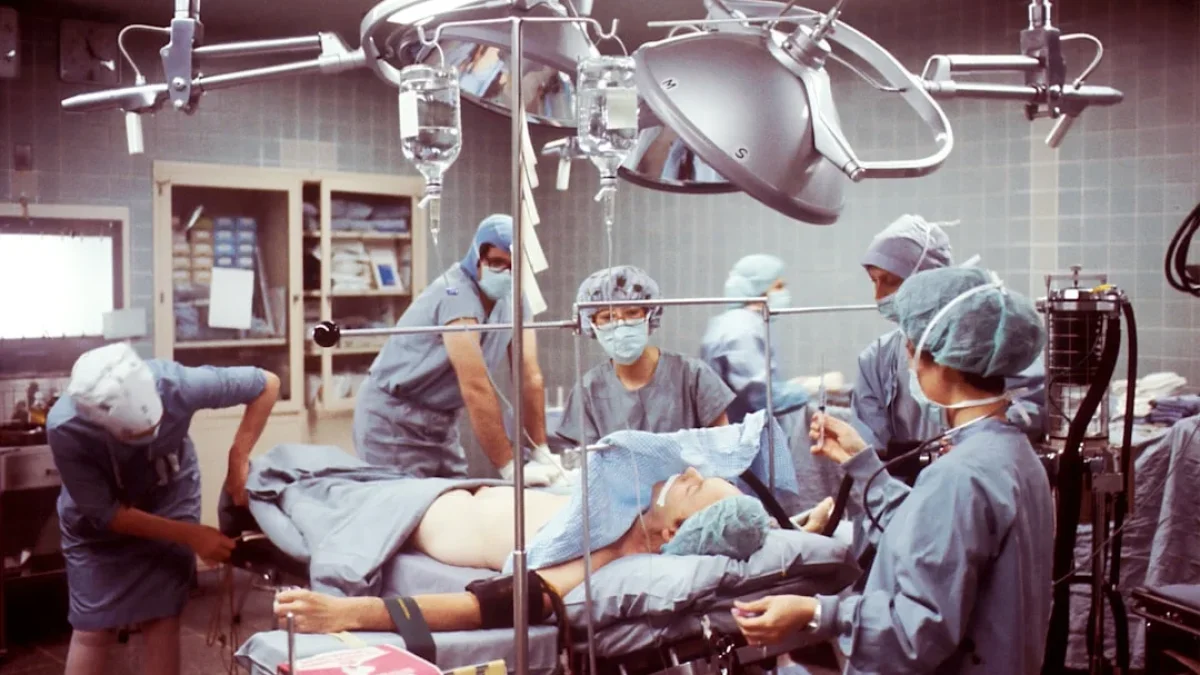

Veo-3は手術映像を見た目だけ忠実に生成できますが、手技や器具の使い方、解剖学的整合性が欠けると研究者が指摘しました。医療用途には専門家の監修と明示、利用制限が急務です。

見た目は本物、でも中身は別物――Veo-3の落とし穴

映画の小道具のようにリアルな手術映像が出てきたら、あなたは信じますか?

今回、Googleの映像生成AI「Veo-3」を研究者が実際の手術映像で検証したところ、見た目は高精度でも医療的な“意味”は欠けていることが明らかになりました。

Veo-3とは?一言で言うと

Veo-3は映像生成を得意とするAIモデルです。学習は主に視覚的リアリズムに重きが置かれます。ですから、人の目には本物そっくりに映る映像を作れますが、それが「正しい医療情報」を意味するとは限りません。

検証で見つかった問題点

研究者の評価では、Veo-3の生成映像に次のような欠点がありました。

- 手術手順の順序が不自然。実際のプロセスとは合わない。

- 器具の使い方が誤っている。持ち方や操作が現実的でない場面がある。

- 解剖学的整合性が欠落。臓器や組織の位置・構造が不正確。

見た目はリアルでも、“やり方”や“結果”が現実と合わない。これは、映画の小道具と本物の医療器具を見分けられないのと同じです。

なぜ放置できないのか?リスクを想像してみる

リアルに見える偽の手術映像が流通すると、次のような問題が起き得ます。

- 患者や一般市民が誤解する。信頼や安全への不安が広がる。

- 医療教育で誤用されれば、誤った学習につながる。

- 医療機関や医師の評判が不当に損なわれる可能性がある。

視覚的な説得力があるだけに、誤情報の影響は大きくなります。

現実的な対策案

完全な解決は一朝一夕ではありませんが、現時点で考えられる実務的な対処は次の通りです。

- 第三者による継続的な検証を実施する。モデルの限界を明らかにする。

- 医療用途での利用制限を設ける。研究やデモ以外での公開を慎重に扱う。

- 生成物への明確なラベリングを義務化する。偽造の可能性を一目で示す。

- 専門家による監修・検証を必須にする。医学的妥当性を担保するため。

簡単に言えば、見た目の“うまさ”だけで放置しない仕組みが必要です。

Veo-3だけの問題か、それとも一般課題か

今回の報告はVeo-3の検証結果ですが、問題自体は映像生成AI全般に共通します。視覚的リアリズムを評価軸にしすぎると、専門領域の妥当性が見落とされがちです。

そのため、医療や安全が絡む分野での応用には、領域固有の評価指標を導入する必要があります。

教訓とこれから

生成AIの進化は目覚ましい一方で、新しいリスクも生んでいます。今回のケースはその良い警鐘です。

まずはデモや研究以外での医療映像自動生成を慎重に扱い、専門家の監修とラベリングを義務付ける。これが現実的な第一歩でしょう。

私たちは便利さとリスクのバランスを常に問い続ける必要があります。見た目にだまされず、中身を見る目を持ち続けましょう。